ベクタデータは拡大しても劣化がないが,データサイズが大きいため,環境によっては動作が極端に重くなる.

これといった決定打があるわけではないが,事前の準備があると少しは取り扱いが楽になる.

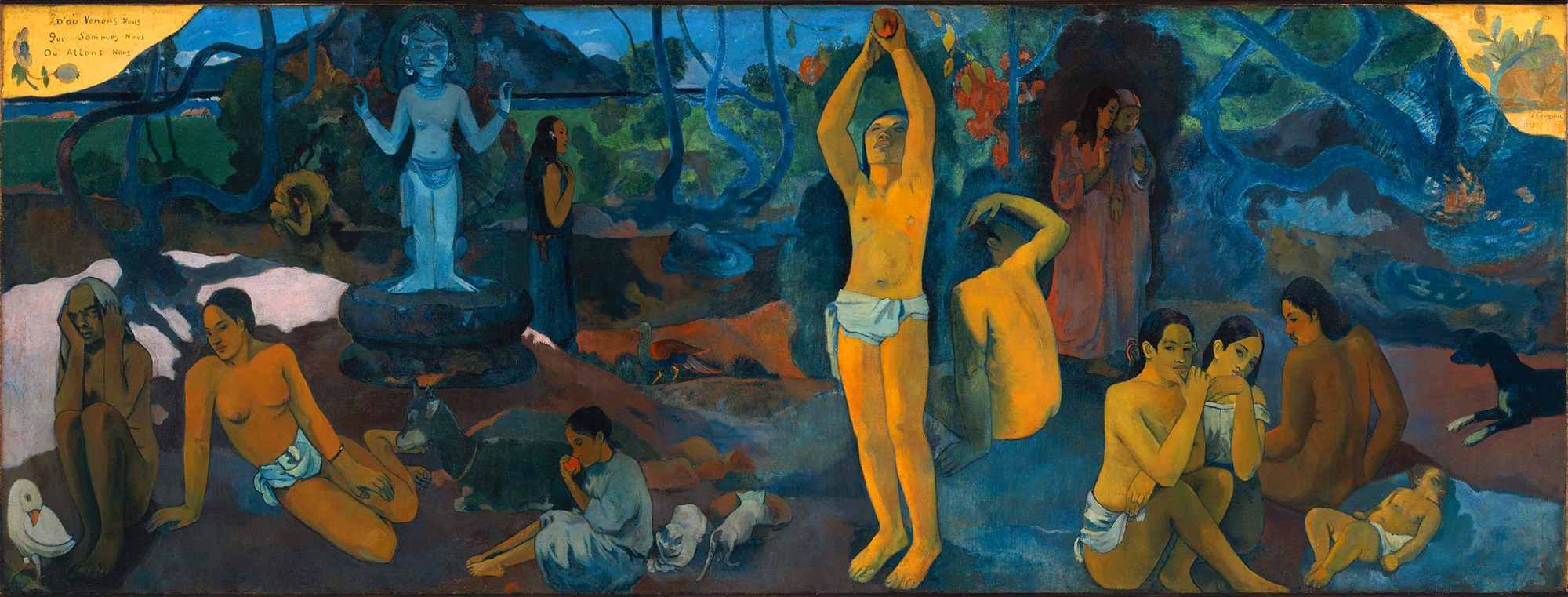

Co-evolution of human and technology

ベクタデータは拡大しても劣化がないが,データサイズが大きいため,環境によっては動作が極端に重くなる.

これといった決定打があるわけではないが,事前の準備があると少しは取り扱いが楽になる.

EXCEL のワークシートの仕様上,100 万件を超えるデータは扱えない.これは大規模なデータを扱う際の制約である.180万件のデータをPower Queryで処理してEXCELがオーバーフローした話 でも述べたが,この制約を乗り越えてデータをインポートするにはデータモデルに読み込むほかはない.

SQL Server で PowerQuery が使えればこういった制約を回避できるのだが,ないものは仕方がない.今回は PowerPivot を用いてデータモデルに蓄積したデータを取り出す方法を見つけたので備忘録として記す.

EXCEL のワークシートに格納できるレコード数は 1,048,576 行である.今回 e-Stat からダウンロードしたファイルをピボット解除したらその上限を超えてしまったのでその記事を書こう.

日本の人口統計は総務省が 5 年おきに行う国勢調査が元になっている.日本の市の人口順位をEXCELにダウンロードして散布図に描くでは日本全国の都市の人口増減率と人口の関係を時系列で流すとどう推移するか予測した.今回はその予測が実態と合っているか乖離しているかの検証を行う.

過去5年間の人口増減率から自治体の将来を予測するでは日本の都市の運命を占った.その元となるデータをダウンロードして散布図にする方法を述べる.